Introduction à la Data Warehousing

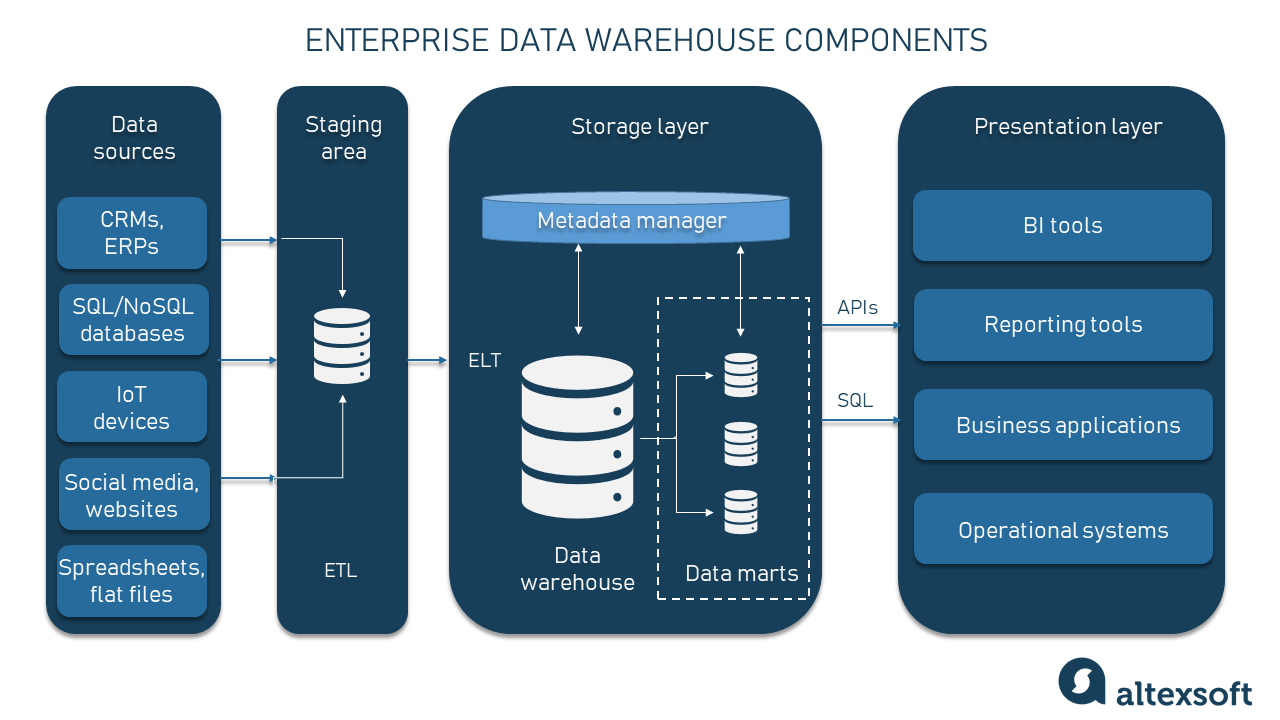

Les données d'une entreprise sont souvent dispersées à travers différents systèmes : bases de données opérationnelles, API, pages web, fichiers Excel, outils CRM, ERP, etc. Cette fragmentation rend complexe leur exploitation efficace pour répondre aux besoins analytiques. C’est ici qu’intervient le Data Warehouse : centraliser les données dans un entrepôt unique afin de fournir une vue fiable pour les rapports, l’analyse et la prise de décision stratégique.

Définition#

Un Data Warehouse (entrepôt de données) est une base de données spécialisée conçue pour soutenir l'analyse des données à grande échelle. Contrairement aux bases de données opérationnelles, orientées vers les transactions quotidiennes, un Data Warehouse est optimisé pour interroger et analyser les données historiques.

Il repose sur une architecture relationnelle où les données sont organisées dans des tables structurées selon des modèles spécifiques :

- Modèle en étoile : les données sont organisées autour d’une table centrale (table des faits), connectée à plusieurs tables de dimensions.

- Modèle en flocon : une extension du modèle en étoile où les dimensions sont normalisées pour réduire les redondances.

Cette structuration permet d'améliorer les performances et d'assurer une clarté dans la navigation entre les données.

OLTP vs OLAP#

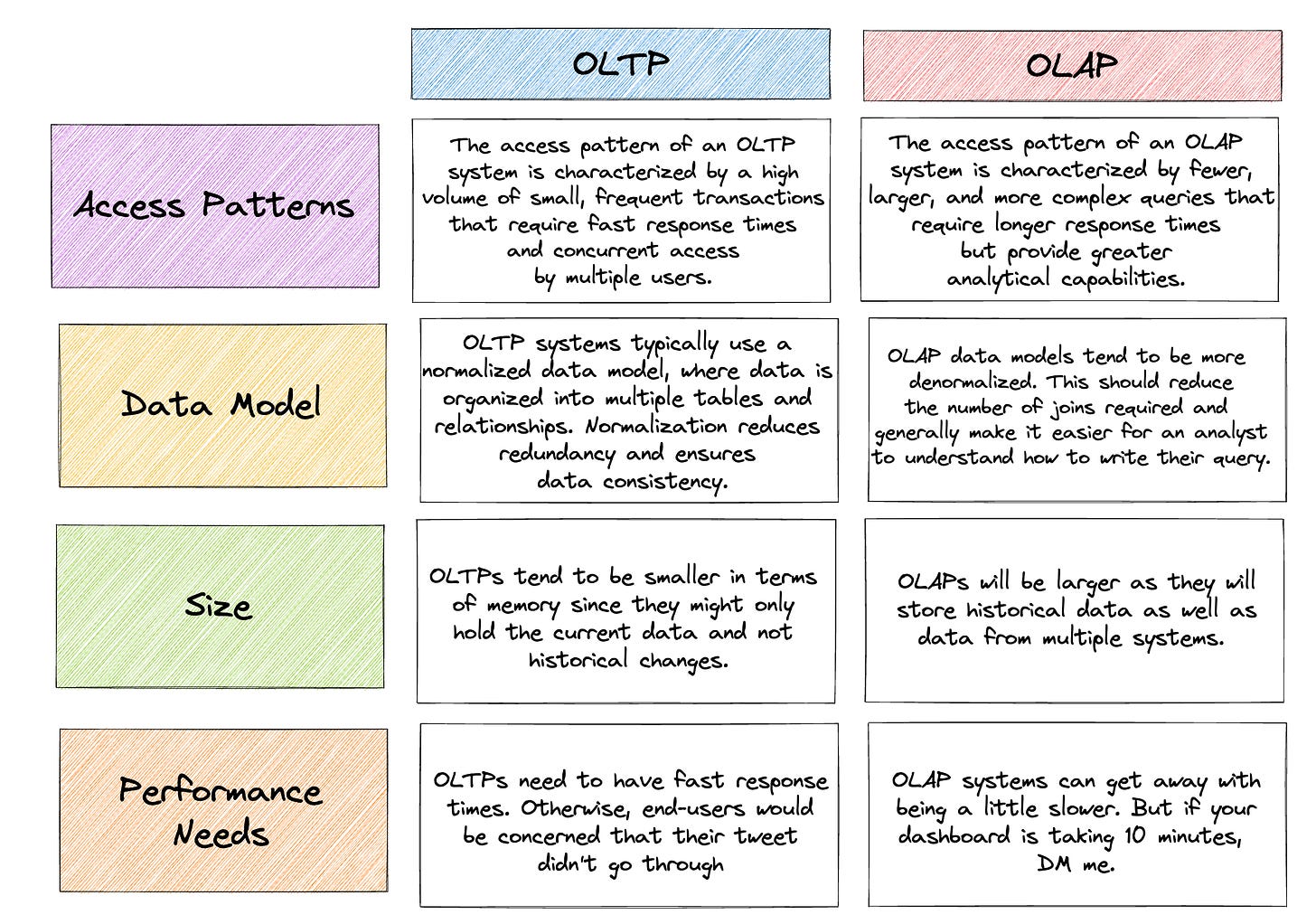

OLTP (Online Transaction Processing)#

Les bases de données OLTP sont conçues pour gérer les transactions opérationnelles en temps réel. Elles sont utilisées dans les systèmes de production, tels que les applications de gestion des stocks, les systèmes bancaires, ou encore les plateformes de commerce en ligne.

OLAP (Online Analytical Processing)#

Les bases de données OLAP, en revanche, sont spécialement conçues pour les analyses de données complexes. Les données provenant des bases OLTP sont extraites, transformées et chargées (processus ETL) dans un environnement OLAP où elles sont optimisées pour l’analyse.

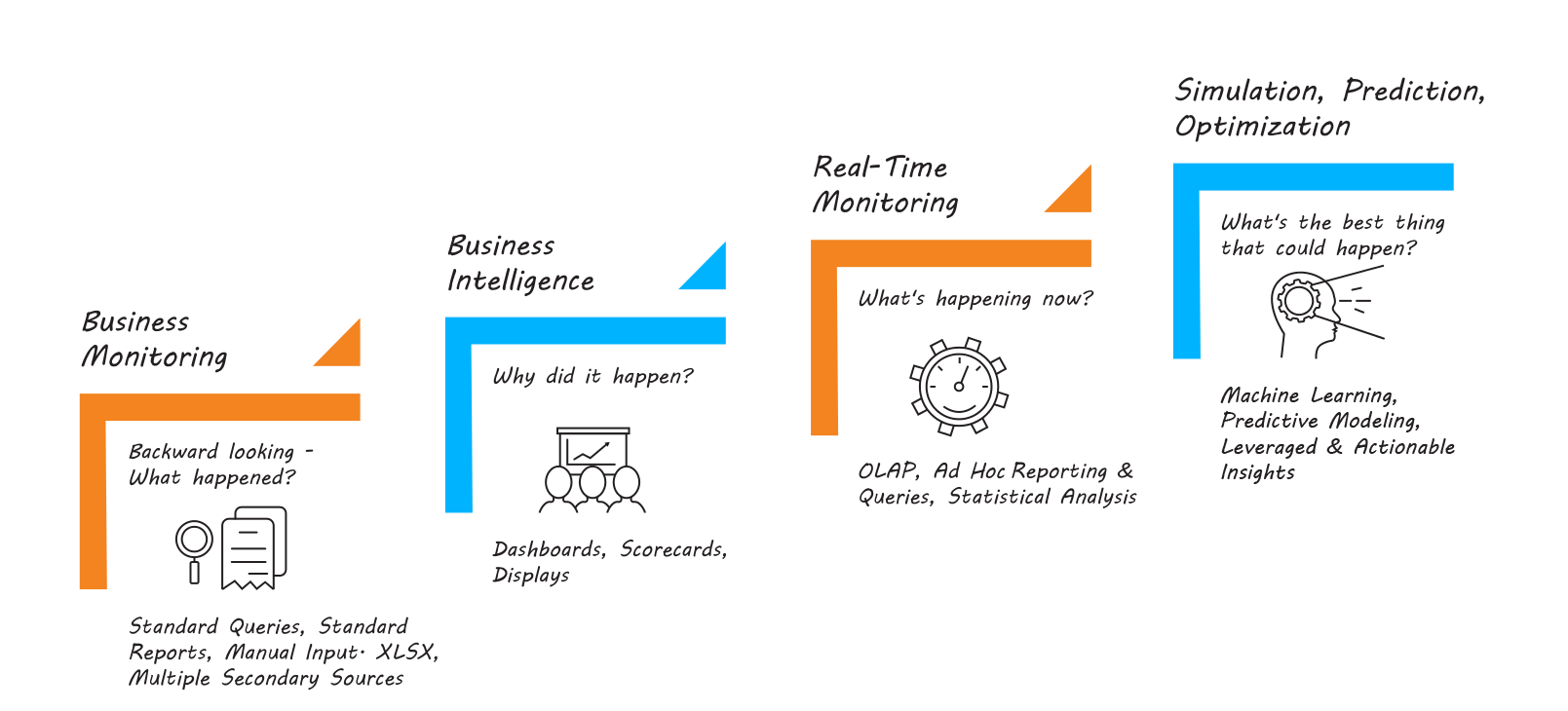

Les systèmes OLAP que nous appelons simplement Data Warehouse ou Datamart sont utilisés pour créer des tableaux de bord, générer des rapports, et effectuer des analyses stratégiques, permettant aux entreprises de prendre des décisions basées sur des données consolidées.

Intégration des données#

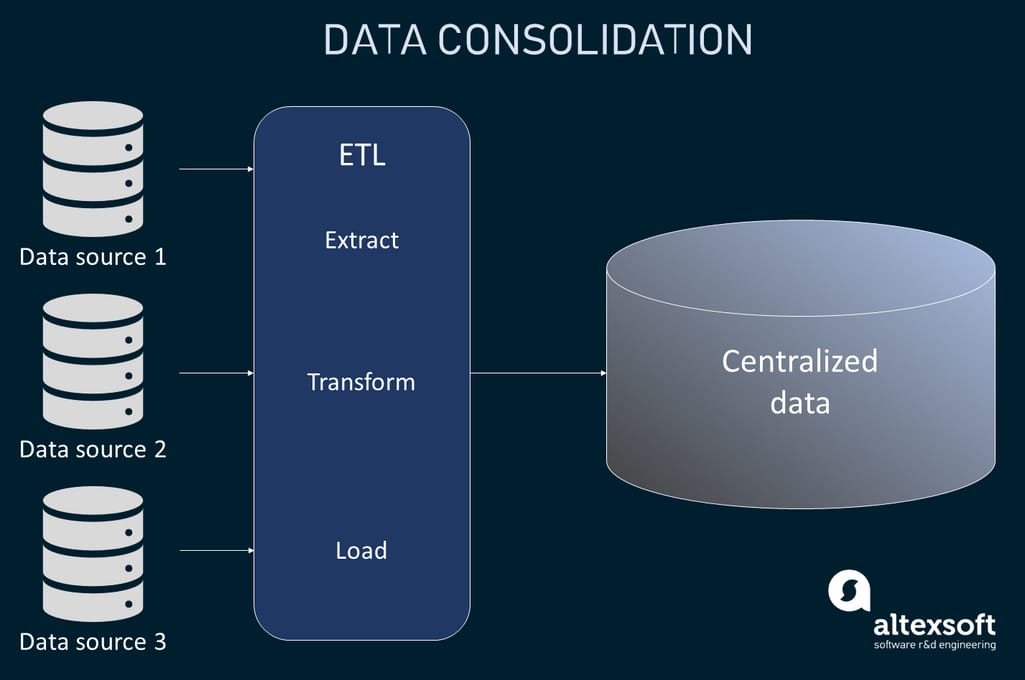

L'intégration des données est une étape essentielle dans la mise en place d'un Data Warehouse. Elle consiste à collecter et à unifier des données provenant de multiples sources (bases de données, API, fichiers CSV). L’objectif est de garantir une qualité des données, en éliminant les doublons et en résolvant les incohérences pour obtenir une vue unique et fiable.

Dans la pratique, des extractions des données en fichiers csv/txt (ce sont les fameux dumps) sont effectuées tôt le matin pendant les heures de faible utilisation des systèmes opérationnels.

ETL#

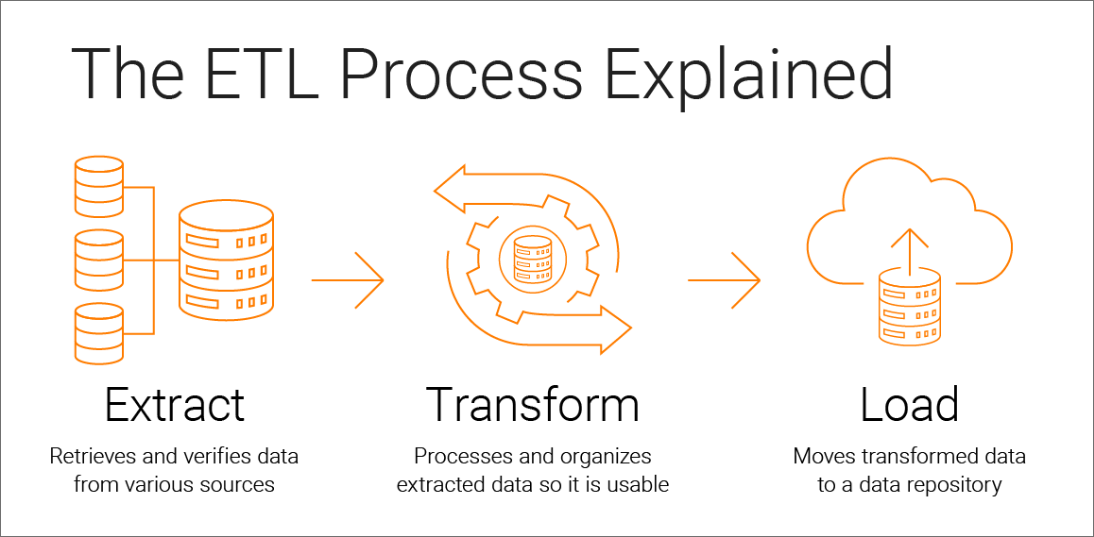

L'acronyme ETL signifie :

- Extraction : Les données sont extraites de différentes sources.

- Transformation : Les données brutes sont nettoyées, enrichies et adaptées au format requis par le Data Warehouse.

- Chargement : Les données transformées sont stockées dans l’entrepôt. Les outils ETL (comme Talend, Informatica ou Apache Nifi) jouent un rôle clé en automatisant ce processus, ce qui garantit efficacité et fiabilité.

Reporting et charges de travail ad hoc#

Une fois les données centralisées, le Data Warehouse devient le point central pour toutes les analyses et visualisations. Cela inclut :

- Rapports périodiques : production automatisée de rapports pour les équipes opérationnelles et stratégiques.

- Charges de travail ad hoc : analyses ponctuelles et personnalisées pour répondre à des questions spécifiques, souvent effectuées via des outils comme Power BI, Tableau ou SQL.

Le Data Warehouse doit être conçu pour gérer ces charges de travail tout en assurant des temps de réponse rapides, même avec de grandes quantités de données.

Références#

- Data Warehouse : Qu’est-ce que c’est ?

- OLTP Vs OLAP – What Is The Difference

- Data Integration: Approaches, Techniques, Tools, and Best Practices for Implementation

- What is ETL (extract transform load)?

Dans la prochaine section, nous aborderons un sujet tout aussi fondamental : la gouvernance des données. Cette discipline est cruciale pour garantir le succès à long terme de tout projet analytique, en assurant la qualité, la sécurité et la conformité des données au sein de l'organisation.